DeepSeekV3技术报告.pdf

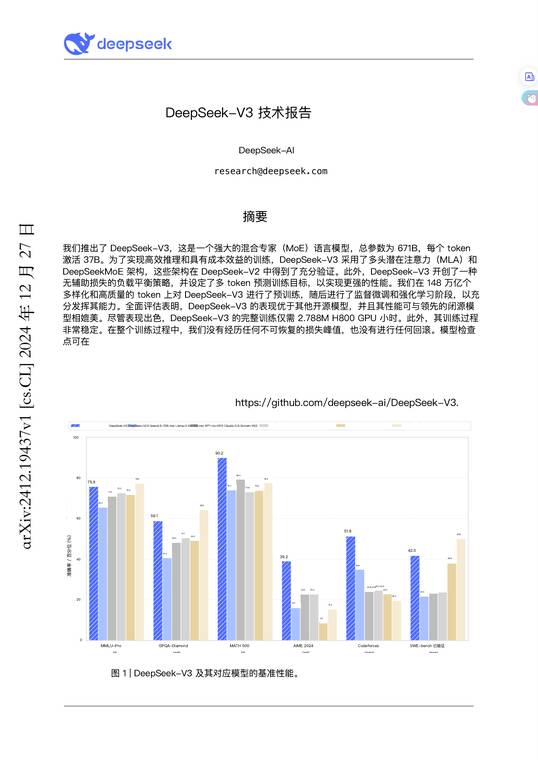

摘要 : DeepSeek-V3是由DeepSeek-AI推出的混合专家(MoE)语言模型,拥有671B的总参数和每个token激活37B的能力。该模型采用多头潜在注意力(MLA)和DeepSeekMoE架构,以实现高效推理和成本效益训练。DeepSeek-V3还引入了无辅助损失的负载平衡策略和多token预测训练目标,以提升性能。模型在148万亿个高质量token上进行了预训练,并经过监督微调和强化学习阶段以发挥最大潜力。评估显示,DeepSeek-V3的性能优于其他开源模型,并可与领先的闭源模型相媲美。训练过程稳定,无需回滚,且训练成本相对较低。模型检查点可在GitHub上找到。DeepSeek-V3在多个基准测试中表现出色,包括MMLU-Pro、GPQA-Diamond、MATH500、AIME2024、Codeforces和SWE-bench等。

相关报告

-

1.01 MB 16页 2025全球技术报告之能源行业洞察.pdf

-

14.72 MB 26页 月狐报告|技术深化、领域融合,持续增长的AI市场-AI行业月度报告(2024.9).pdf

-

6.08 MB 23页 动漫产业的创新驱动:3D动漫制作技术如何引领视觉艺术新潮流 头豹词条报告系列.pdf

-

3.89 MB 46页 2024年十大新兴技术报告(英)-世界经济论坛-2024.6-46页.pdf

-

3.2 MB 86页 2024年十大数字技术趋势与其安全挑战报告.pdf

-

8.27 MB 33页 2023技术趋势报告.pdf

-

1.27 MB 33页 2024年十大顶级策略技术趋势报告-Garner-202311.pdf

-

3.94 MB 32页 2023全球技术报告-毕马威-202311.pdf

-

6.35 MB 73页 AIGC行业专题报告:从文生图到文生视频—技术框架与商业化-国海证券-20231102.pdf

-

20.25 MB 54页 甲子光年2023中国AIGC市场研究报告ChatGPT的技术演进变革风向与投资机会分析54页.pdf